Detecting blueberry maturity under complex field conditions using improved YOLOv8

-

摘要:

为了快速精确识别田间复杂环境下的蓝莓果实的成熟度,该研究基于YOLOv8提出了一种蓝莓成熟度轻量化检测模型(MSC-YOLOv8)。首先,为了有效减少参数量,提高模型的运行速度,采用MobileNetV3为主干特征提取网络进行特征信息的提取,有利于田间复杂环境下的检测。其次,在主干特征提取网络中插入卷积注意力机制模块(convolutional block attention module,CBAM),以提高深度学习网络对蓝莓特征提取的能力。最后,引入SCYLLA-IoU(SIoU)作为YOLOv8的边界框回归损失函数,以解决真实框与预测框角度不匹配的问题,进一步提高蓝莓成熟度识别的准确率。通过试验得出改进的MSC-YOLOv8模型相较于YOLOv8平均精度均值(mean average precision,mAP)提升了3.9个百分点,单张图片平均检测时间比原YOLOv8减少了3.97 ms。改进的MSC-YOLOv8模型在蓝莓数据集上取得了较优的结果,与SSD和CenterNet模型对比,mAP分别提升了4.6和1.1个百分点,在检测速度和准确率方面均有优势。该研究可为田间复杂环境下蓝莓机器人采摘提供技术支持。

Abstract:To rapidly and accurately identify blueberry fruit maturity under complex field conditions, a lightweight detection model for blueberry maturity (MSC-YOLOv8)was proposed based on YOLOv8n. YOLOv8n, a recent addition to the YOLO series, offers the fastest detection speed and the lightest architecture, albeit with slightly lower recognition accuracy. Considering these attributes, YOLOv8n was chosen as the foundational model for blueberry maturity recognition. Compared to traditional object detection algorithms, YOLOv8 boasts a significantly faster detection speed. By using a single forward propagation to obtain detection results for all targets simultaneously, YOLOv8 achieves low latency, making it suitable for real-time applications. Additionally, YOLOv8 demonstrates high detection accuracy, rivaling advanced object detection algorithms, and excels particularly in detecting small targets. These advantages make YOLOv8 a superior choice for this application. Before training the model, the original blueberry datasets need to be augmented using Deep Convolution Generative Adversarial Networks (DCGAN) to generate additional blueberry images.This aims to generate diverse blueberry images to enhance the datasets, thereby improving the model's capability for detecting and recognizing blueberries in complex field environments. Firstly, to reduce the number of parameters and improve the model's running speed, MobileNetV3 was employed as the backbone feature extraction network, which was conducive to detection in complex field environments. Secondly, to enhance the network's ability to extract features from blueberries, the Convolutional Block Attention Module (CBAM) was integrated into the backbone feature extraction network. Finally, by introducing SCYLLA-IoU (SIoU) as the bounding box regression loss function for YOLOv8n, the issue of angle mismatch between the ground truth and predicted boxes was addressed, further improving the accuracy of blueberry maturity identification. In terms of the backbone feature extraction network, compared with MobileNetV3, ShuffleNet, VanillaNet, and YOLOv8's own backbone CspdarkNet, the experimental results showed that MobileNetV3 as the backbone network of YOLOv8 had the highest mAP value. Additionally, CBAM demonstrated the best mAP performance in various attention mechanisms such as CBAM, SE, ShuffleAttention and MHSA. When assessing bounding box regression loss functions, SIoU outperformed GIoU, EIoU, and CIoU in terms of mAP. Through three key improvements, this study proposed a lightweight network model, MSC-YOLOv8, for blueberry fruit maturity detection,ensuring the real-time performance and accuracy. The results showed that the improved MSC-YOLOv8 model was 3.9 percentage points higher than that of YOLOv8. The average detection time was reduced by 3.97 ms compared with the original YOLOv8. Compared with SSD and CenterNet models, the improved model achieved better results on the blueberry dataset, and the average precision mean mAP is increased by 4.6 and 1.1 percentage points, respectively, which has advantages in detection speed and accuracy. This research provides technical support for blueberry picking robots to perform picking work under complex conditions in the fields.

-

Keywords:

- blueberry /

- YOLOv8 /

- MobileNet V3 /

- CBAM /

- ripeness /

- loss function

-

0. 引 言

根据2017年世界蓝莓大会暨高峰论坛(云南曲靖)的预测,中国在2026—2027年度将成为世界最大的蓝莓生产国[1]。据相关数据,全国蓝莓栽培面积6.64万hm2,总产量34.72万t,鲜果产量23.47万t[2]。蓝莓采摘工作量很大,行业正逐步从人工采摘向智能化采摘转型,其中确定蓝莓的成熟度是智能化采摘的首要任务。因此,在自然环境下准确识别蓝莓的成熟度尤为重要。

目前国内外研究学者采用深度学习方法对水果成熟度级别进行分类研究均取得了一定的进展。MUTHA等[3]采用深度学习技术检测西红柿的成熟度,创建了图像的自定义数据集,并使用卷积神经网络YOLOv3检测西红柿的成熟度并确定其位置。KO等[4]设计了基于物体检测深度学习模型的番茄成熟度实时分类系统,该系统成熟度分类的计算速度为97帧/s(frames per second),平均准确率为91.3 %。SU等[5]提出了一种SE-YOLOv3-MobileNetV1模型,该模型能够区分4种成熟度的番茄,番茄的平均精度值达到97.5%。FAN等[6]为了提高草莓鉴定和采摘的准确性,用经过暗通道处理后的图片进行训练以增加夜间低照度草莓的识别率。DANH等[7]采用深度迁移学习技术对番茄进行分类研究,试验结果表明,VGG19模型在检测樱桃番茄成熟程度时精度为94.14%。CHEN等[8]提出了一种柑橘类水果成熟度检测方法,该方法结合了视觉显著性和卷积神经网络,以识别柑橘类水果的3个成熟水平。蓝莓果实的成熟度对于蓝莓种植者和蓝莓育种专家进行蓝莓采摘非常重要。MACEACHERN等[9]将YOLOv4应用于蓝莓成熟度检测,结果表明该算法对蓝莓成熟度检测具有较高的准确性,但由于YOLOv4模型的计算量较大,后续迁移到小型嵌入式设备会导致算法速度显著降低。王立舒等[10]设计改进了YOLOv4-Tiny网络,在遮挡与光照不均等复杂场景中,对蓝莓的不成熟、欠成熟、成熟的平均精度能达到96.24%,平均检测时间为5.723 ms,可以同时满足蓝莓果实识别精度与速度的需求。

上述研究结果表明采用深度学习模型可有效识别田间水果的成熟度。但对于蓝莓果实成熟度检测方面,未考虑成熟度为过成熟的蓝莓检测,且田间复杂自然环境下蓝莓果实呈簇状且果实密集分布,存在蓝莓果实相互遮挡或者蓝莓果实与蓝莓枝叶相互遮挡的情况,还存在枝叶遮光的情况,使得蓝莓果实光照程度不一。由于这些干扰因素,田间复杂环境下蓝莓果实的精准检测还存在一定难度和挑战。另外原始深度学习模型体积和计算复杂度都很大,受田间工作的边缘设备性能限制,在这些设备上部署模型时难以保证实时性检测的需求。因此进行模型轻量化研究较为重要。本研究提出一种基于YOLOv8的蓝莓检测方法,改进YOLOv8的主干网络,实现了模型的轻量化,在主干网络中嵌入注意力机制,并改进边界框回归损失函数。实现在减少模型参数量的同时,提高模型的检测精度和检测速度,为田间复杂环境下蓝莓采摘机器人进行采摘提供技术支持。

1. 图像数据获取与预处理

1.1 图像采集方法

图像采集于辽宁省沈阳市沈河区东陵路沈阳农业大学的小浆果科研实践基地,每株蓝莓的行距约为1.1 m,适合蓝莓采摘机器人采摘。分别采集晴天和阴天下的蓝莓图像,时间为上午9:00,中午12:30,下午3:00。采集图像所使用的设备是iphone13 Pro 自带的相机,长焦镜头光圈为2.8,广角镜头光圈为1.5,共采集蓝莓图像1 000张。蓝莓图像的分辨率为4 032像素×3 024像素,图像格式为JPG。

根据蓝莓采摘机器人在蓝莓果园进行自动化采摘的实际情况及专家的建议,将蓝莓的成熟度分为4个类别,分别为未成熟、欠成熟、成熟、过成熟,具体如图1所示。

蓝莓在田间生长时存在背景叶干扰、枝叶遮挡、果实重叠和逆光等复杂环境,如图2所示。

1.2 图像数据预处理

为了增强数据的多样性,使模型得到更好的训练,需要进行图像预处理。首先按照7∶2∶1的比例将采集图像分为训练集、验证集、测试集。然后对训练集进行数据增强,本研究利用深度卷积生成对抗网络(convolution generative adversarial networks,DCGAN)[11]生成蓝莓图像进行数据增强,将所采集的蓝莓图像输入到DCGAN网络之中,生成9 000张蓝莓图像。测试集图像中含有过成熟果实224,成熟果实1 053,欠成熟果实342,未成熟果实207。然后使用labelImg图像数据标注软件来对蓝莓图像进行标注。

2. MSC-YOLOv8目标检测网络

2.1 YOLOv8网络架构

YOLOv8是YOLO系列推出的目标检测模型之一。YOLOv8提供了5个版本,分别为YOLOv8n、YOLOv8s、YOLOv8m、YOLOv8l和YOLOv8x。在这几个版本中,YOLOv8n虽然识别精度稍低,但是其模型架构最轻量化,检测速度最快[12]。基于这一特性,本研究经过综合考虑,选择YOLOv8n作为蓝莓果实成熟度识别任务的基础模型。

YOLOv8由输入端、主干网络(Backbone)、颈部网络(Neck)、头部网络(Head)4部分组成[13]。主干网络有5个卷积块、4个C2f块、1个SPPF块构成。C2f块相对于YOLOv5主干网络中的C3块,显著减少了参数数量,从而降低计算量。颈部网络采用了路径聚合网络(path aggregation network,PANet)[14],与特征金字塔网络(feature pyramid network,FPN)[15]相比,PANet引入了一种自下向上的路径机制,使得底层信息可以更为顺畅地传递到高层顶部。头部网络将回归分支和预测分支进行分离,这样做收敛更快,效果更好。头部网络的设计将回归分支和预测分支进行了分离,这种设计策略有助于模型在训练过程中更快地收敛,并提升整体性能。

2.2 改进后的YOLOv8目标检测网络

田间复杂环境下的目标检测,在保证蓝莓成熟度分类检测的实时性的同时,应尽可能提高网络对蓝莓果实识别的准确性。本研究基于YOLOv8做了3个改进:

1)将原模型主干网络替换为轻量型MobileNetV3结构。

2)在主干网络中引入卷积注意力机制模块(convolutional block attention module,CBAM)。

3)将原模型的边界框损失函数替换为SIoU。

将改进后的网络命名为MSC-YOLOv8目标检测网络,其主要包含4个部分:输入层、主干特征提取网络、路径聚合网络、输出层,其网络结构如图3所示,首先输入层接受一张640像素×640像素的蓝莓图像,其次送入主干特征提取网络进行特征提取,蓝莓特征图再次送入路径聚合网络进行浅层特征与深层特征的上下融合,最后进入输出层输出预测框并给出类别。

![]() 图 3 MSC-YOLOv8模型架构注:Conv2d为卷积,Concat为通道数相加的特征融合方式,BN为批量归一化,CBAM为卷积注意力块,MNI为MNIneck,Upsample代表上采样。Figure 3. Network structure of MSC-YOLOv8Note: Conv2d is convolution, Concat is the feature fusion method of adding the number of channels, BN is bath normalization, CBAM is the convolutional attention block, MNI represents MNIneck, and Upsample represents upsampling.

图 3 MSC-YOLOv8模型架构注:Conv2d为卷积,Concat为通道数相加的特征融合方式,BN为批量归一化,CBAM为卷积注意力块,MNI为MNIneck,Upsample代表上采样。Figure 3. Network structure of MSC-YOLOv8Note: Conv2d is convolution, Concat is the feature fusion method of adding the number of channels, BN is bath normalization, CBAM is the convolutional attention block, MNI represents MNIneck, and Upsample represents upsampling.MSC-YOLOv8的主干特征提取网络由轻量型网络MobileNetV3和CBAM注意力机制构成,具体为CBH模块、MNI模块、CBAM模块、SPPF模块,如图3所示。CBH模块由一个卷积层连接一个批量正则化(bath normalization,BN)再连接一个HSwish函数组成,用作蓝莓图像的第一次处理;MNI模块用作蓝莓图像特征的提取;CBAM注意力机制则进一步加强特征的提取。蓝莓图像经过主干网络(backbone)获得3个有效特征层,并将这3个有效特征层传入路径聚合网络(neck)。路径聚合网络通过自上而下和自下而上的融合方式将这3个有效特征层进行特征融合。最后将融合后的特征分别送入3个头部网络,输出预测框并给出类别。

2.2.1 改进主干特征提取网络

在田间复杂环境下进行实时检测时,由于原模型的体积和计算复杂度较大,直接部署于边缘设备面临挑战。为实现模型的高效运行,需进行模型轻量化设计。模型轻量化旨在减小模型规模、降低计算需求,同时尽量保持或提升模型的性能。在这一背景下,MobileNetV3作为一种轻量级网络模型,相较于原YOLOv8主干网络,显著减少了参数量和计算量,为在边缘设备上的实时检测提供了更为可行的解决方案[16]。所以本研究采用MobileNetV3作为改进YOLOv8模型的主干网络。MobileNetV3是采用NAS(neural architecture search)搜索的一种算法[17]。在MobileNetV3中,大量使用1×1和3×3的卷积代替原版本5×5的卷积,这一改变显著减少了参数量。这样设计不仅保留了高维特征空间,同时也减少了反向传播的延迟。此外,MobileNetV3还引入残差块和轻量级的注意力机制,这种轻量级的注意力模块被设计为瓶颈结构,可以更好地提取特征。

在原版本的基础上,MobileNetV3重新设计了耗时层结构,减少第一层卷积层的卷积核个数,由32减少为16,并且精简了最后一层。另外,为了进一步提高模型的性能MobileNetV3使用了性能更好的激活函数,将原来的swish激活函数改为h-swish激活函数,该激活函数的计算和求导过程更加简单,因此减小了计算量。经过这些优化和改进,MobileNetV3实现了模型的轻量化,具有较小的模型体积和较低的计算复杂度。

MobileNetV3网络的结构如表1所示,本研究使用的是MobileNetV3的small版本,目的是降低模型的参数量。图4为MobileNetV3中特有的的bneck结构。

表 1 MobileNetV3网络结构Table 1. Network structure of MobileNetV3输入

Input模块

Layer卷积核

大小

Kernel sizeExp Size 输出通

道数

Output channelSE注意

力机制

SE attention非线性

激活函数

Nonlinearities步距

Stride6402×3 conv2 d 3×3 - 16 × HS 2 1122×16 bneck 3×3 16 16 √ RE 2 562×16 bneck 3×3 72 24 × RE 2 282×24 bneck 3×3 88 24 × RE 1 282×24 bneck 5×5 96 40 √ HS 2 142×40 bneck 5×5 240 40 √ HS 1 142×40 bneck 5×5 240 40 √ HS 1 142×40 bneck 5×5 120 48 √ HS 1 142×48 bneck 5×5 144 48 √ HS 1 142×48 bneck 5×5 288 96 √ HS 2 72×96 bneck 5×5 576 96 √ HS 1 72×96 bneck 5×5 576 96 √ HS 1 72×96 conv2 d 1×1 - 576 √ HS 1 72×576 Pool 7×7 - - × - 1 12×576 conv2 d,NBN 1×1 - 1024 × HS 1 12× 1024 conv2 d,NBN 1×1 - k × - 1 注:Layer中的bneck表示MobileNetV3中的bneck结构,NBN表示不使用BN;Exp size表示bneck中的第一层1×1卷积升维之后的维度大小(第一个bneck没有1×1卷积升维操作);Output channel中的 k 表示bneck最终输出的channel个数;SE attention中的“×”表示不使用SE注意力机制;“√”表示使用SE注意力机制;Nonlinearities中的HS表示HardSwish,RE表示ReLu;stride表示步长(stride=2,长宽变为原来一半)。 Note: The bneck in the layer represents the unique bneck structure in MobileNetV3, as shown in Figure 4, and the NBN indicates that BN is not used. Exp size indicates the first layer of 1×1 convolution in bneck, and how much the dimension is ascended to (the first bneck does not have a 1×1 convolutional dimension upscaling operation); k in the output channel indicates the number of channels that bneck outputs in the end. The "×" in SE attention means that the SE attention mechanism is not used; "√" indicates the use of the SE attention mechanism; HS in Nonlinearities means HardSwish, RE means ReLu; stride represents the step size (stride = 2, the length and width become half). 2.2.2 增加注意力机制

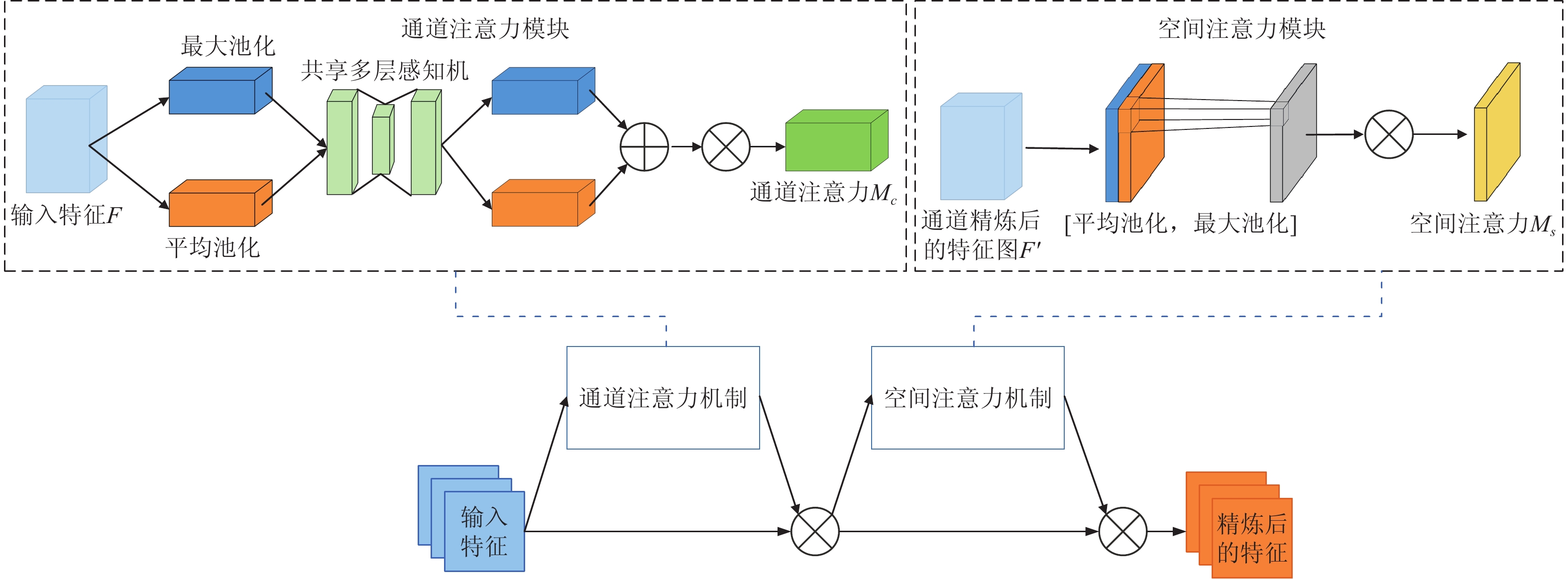

为了提升YOLOv8n模型在蓝莓特征提取方面的性能,本研究在主干网络的不同层级中嵌入了卷积注意力机制模块。

卷积注意力机制模块是一种结合了空间(spatial)和通道(channel)的注意力机制模块[18]。CBAM的轻量化程度高,内部无大量卷积结构,只有少量池化层和特征融合操作,这种结构避免了卷积运算带来的大量计算,使得其模块复杂度低,计算量小。此外,CBAM因其简洁而灵活的结构,展现出了较强的通用性,可广泛应用于不同的神经网络架构中。

蓝莓特征图在CBAM中的运算流程如图5所示,具体过程为:先分别对蓝莓特征图进行全局最大池化(MaxPool)和全局平均池化(AvgPool),对特征映射基于两个维度压缩,获得两张不同维度的特征描述。

池化后的特征图共用一个多层感知器网络,先通过1×1卷积降维再1×1卷积升维。将两张蓝莓特征图叠加layers.add(),经过sigmoid激活函数归一化特征图的每个通道的权重。将归一化后的权重和输入特征图相乘。然后对通道注意力机制的输出特征图进行空间域的处理。首先,特征图分别经过基于通道维度的最大池化和平均池化,将输出的两张特征图在通道维度堆叠 layers.concatenate()。然后使用1×1卷积调整通道数,最后经过sigmoid函数归一化权重。将归一化权重和输入特征图相乘。输入特征图经过通道注意力机制,将权重和输入特征图相乘后再送入空间注意力机制,将归一化权重和空间注意力机制的输入特征图相乘,得到最终的特征图。

2.2.3 优选损失函数

传统的目标检测损失函数(GIoU[19]、ICIoU[20]和YOLOv8采用的CIoU[21]等)主要关注预测框和真实框的距离、重叠区域和纵横比等边界框回归指标。然而,并没有考虑所需真实框与预测框之间不匹配的方向。这种不足导致收敛速度较慢且效率较低,因为预测框可能在训练过程中位置不稳定并最终产生更差的模型。针对以上问题,本研究采用SIoU损失函数替换原损失函数。SIoU[22-23]包含4个损失,具体为角度损失、距离损失、形状损失和交并比损失。

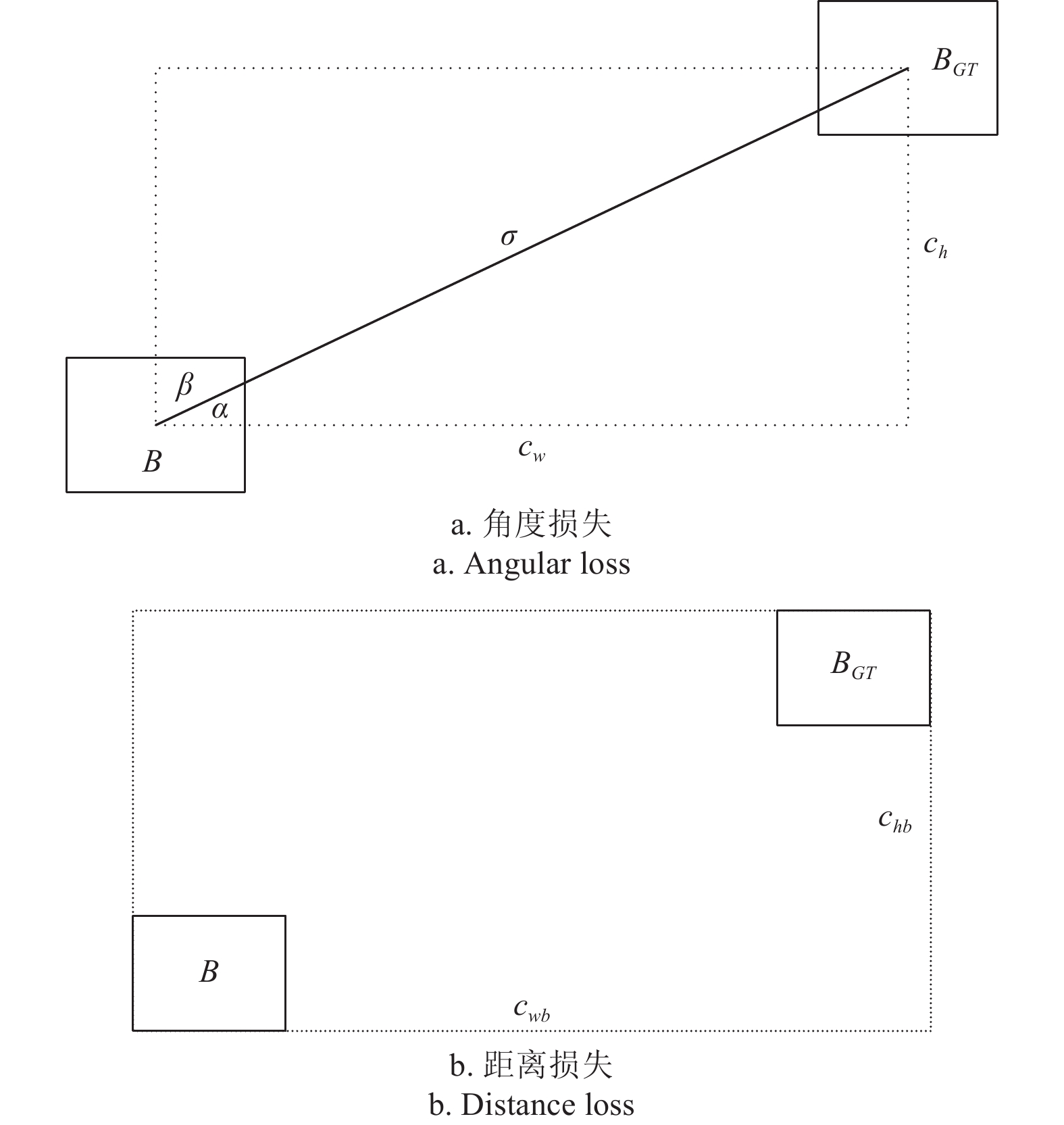

1)角度损失为模型输出的角度与真实角度之间的差异,如图6a所示。具体计算如下所示。

![]() 图 6 角度损失和距离损失示意图注:B为预测边界框,BGT为真实边界框,图a以真实框中心点和预测框中心点作为对角顶点形成一个矩形,cw和ch为矩形的宽度和高度,σ为矩形的对角线长度,α为σ与cw形成的角度度数,β为σ与ch形成的角度度数;图b中cwb和chb为预测框与真实边界框的最小外接矩形的宽度和高度。Figure 6. Schematic diagram of angular loss and distance lossNote: B is the prediction bounding box, BGT is the real bounding box, Fig. a takes the center point of the real box and the center point of the prediction box as diagonal vertices to form a rectangular rectangle, the cw and ch are the width and height of the rectangle, the σ is the diagonal length of the rectangle, the α is the degree of angle formed by the σ and the cw, and the β is the degree of angle formed by the σ and the ch; In Figure b, cwb and chb are the widths and heights of the minimum enclosed rectangle between the prediction box and the real bounding box.

图 6 角度损失和距离损失示意图注:B为预测边界框,BGT为真实边界框,图a以真实框中心点和预测框中心点作为对角顶点形成一个矩形,cw和ch为矩形的宽度和高度,σ为矩形的对角线长度,α为σ与cw形成的角度度数,β为σ与ch形成的角度度数;图b中cwb和chb为预测框与真实边界框的最小外接矩形的宽度和高度。Figure 6. Schematic diagram of angular loss and distance lossNote: B is the prediction bounding box, BGT is the real bounding box, Fig. a takes the center point of the real box and the center point of the prediction box as diagonal vertices to form a rectangular rectangle, the cw and ch are the width and height of the rectangle, the σ is the diagonal length of the rectangle, the α is the degree of angle formed by the σ and the cw, and the β is the degree of angle formed by the σ and the ch; In Figure b, cwb and chb are the widths and heights of the minimum enclosed rectangle between the prediction box and the real bounding box.Λ=1−2sin2(arcsin(x)−π4) (1) x=chσ=sin(α) (2) σ=√(bgtcx−bcx)2+(bgtcy−bcy)2 (3) ch=max (4) 式中Λ表示角度损失,事实上 \mathrm{s}\mathrm{i}\mathrm{n}\left(\alpha \right) 为直角三角形的对边比斜边。( {b}_{{c}_{x}}^{gt} , {b}_{{c}_{y}}^{gt} )为真实框中心坐标,( {b}_{{c}_{x}} , {b}_{{c}_{y}} )为预测框中心点坐标。

2)距离损失为模型输出位置与真实位置之间的距离,如图6b所示,具体计算如下所示。

\mathit{ \Delta }= 2 -\rm{e} ^{ - \gamma {p_x}} - \rm{e}^{ - \gamma {p_y}} (5) {\rho _x} = {\left( {\frac{{b_{{c_x}}^{gt} - {b_{{c_x}}}}}{{{c_{wb}}}}} \right)^2},{\rho _y} = {\left( {\frac{{b_{{c_y}}^{gt} - {b_{{c_y}}}}}{{{c_{hb}}}}} \right)^2},\gamma = 2 - \mathit{\Lambda} (6) 式中Δ为距离损失,cwb、chb为真实框和预测框最小外接矩形的宽和高。

3)形状损失为模型输出的目标区域与真实目标的形状相似性,具体计算如下所示:

\mathit{\Omega} = \sum\limits_{t = w,h} {{{\left( {1 - {e^{ - {\omega _t}}}} \right)}^\theta }} (7) {\omega _w} = \frac{{\left| {w - {w_{gt}}} \right|}}{{\max \left( {w,{w_{gt}}} \right)}} (8) {\omega _h} = \frac{{\left| {h - {h_{^{gt}}}} \right|}}{{\max \left( {h,{h_{^{gt}}}} \right)}} (9) 式中Ω表示形状损失,w、h预测框的宽和高,wgt、hgt为真实框的宽和高,θ控制对形状损失的关注程度。

4)交并比IoU为模型输出目标框与真实目标框这两个框的交集与并集之间的比值,具体计算如下所示。

\rm{IoU}=\frac{交集A}{并集B} (10) 综上所述,最终SIoU的边框损失函数Lbox定义如下所示。

{L_{box}} = 1 - \rm{IoU} + \frac{{\mathit{\Delta} +\mathit{ \Omega} }}{2} (11) 2.3 训练环境与方法

本研究训练环境如下:CPU为I712700f 2.10 GHz,GPU为RTX

3080 12G,内存为32G,Pytorch版本为1.10.0,Python版本为3.8.0。本研究训练采用随机梯度下降法(stochastic gradient descent,SGD)[24]优化网络参数,SGD优化器的初始学习率(learning rate)设置为0.01,动量(momentum)设为0.923,权值衰减为0.0003 ,共训练150轮。为了准确评估蓝莓成熟度模型的性能。本研究采用准确率(precision,P)、召回率(recall,R)、平均精度均值mAP、检测速度作为蓝莓成熟度分级模型的评价指标[25]。

在评估检测速度时,采用的标准是蓝莓模型识别单张蓝莓图像所需的时间,单位为 ms。

3. 结果与分析

3.1 特征提取网络轻量化改进结果分析

本小节旨在对2.2节所提出的轻量化改进方法进行验证和分析。考虑到当前模型的计算量庞大、参数众多,这不仅占用大量的内存空间,还导致运行效率低下,这些因素均限制了模型在边缘设备上的有效应用部署。为使蓝莓成熟度检测模型能满足边缘设备应用的需要,达到实时检测的要求,本研究基于YOLOv8进行了轻量化改进,并开展了相关试验,以YOLOv8为基础模型,分别使用MobileNetV3、VanillaNet[26]、shufflenet[27]作为YOLOv8的主干网络,并对这4个模型的参数量和检测速度进行了对比,对比结果如表2所示,检测结果如图7所示。

表 2 不同轻量化改进试验结果Table 2. Experimental results of different lightweight improvements模型Models 参数量

Parameters/M检测速度

Detection speed/msYOLOv8 7.86 11.06 YOLOv8-MobileNetV3 7.01 6.89 YOLOv8-Shufflenet 7.06 6.95 YOLOv8-Vanillanet 6.82 6.84 从图7a可知,YOLOv8原模型存在漏检和误识别情况,图片最下方的1个和中间的2个蓝莓没有检测到,而且图片中间的1个欠成熟蓝莓误识别为未成熟蓝莓。从图7b可知,将YOLOv8模型的主干网络更改为ShuffleNet,该算法在多目标图像中存在漏检误识别情况,最下面的蓝莓和中间的2个蓝莓没有被检测到,中间和左边的2个欠成熟蓝莓误识别为未成熟蓝莓,且部分检测框并未完全覆盖整个蓝莓果实,YOLOv8-ShuffleNet的参数量为7.06 M;从图7c可知,将YOLOv8模型的主干网络更改为VanillaNet,该算法在多目标图像中存在漏检和误识别情况,图片最下方的1个和中间的1个蓝莓没有检测到,左边的一个欠成熟蓝莓误识别为未成熟蓝莓,YOLOv8-VanillaNet的参数量为6.82 M;从图7d可知,将YOLOv8模型的主干网络更改为MobileNetV3,该算法在多目标图像中针对蓝莓果实相互遮挡、逆光等情况识别效果都较好,无漏检情况,YOLOv8-MobileNetV3的参数量为7.01 M。所以本研究选取MobileNetV3作为YOLOv8的主干网络。

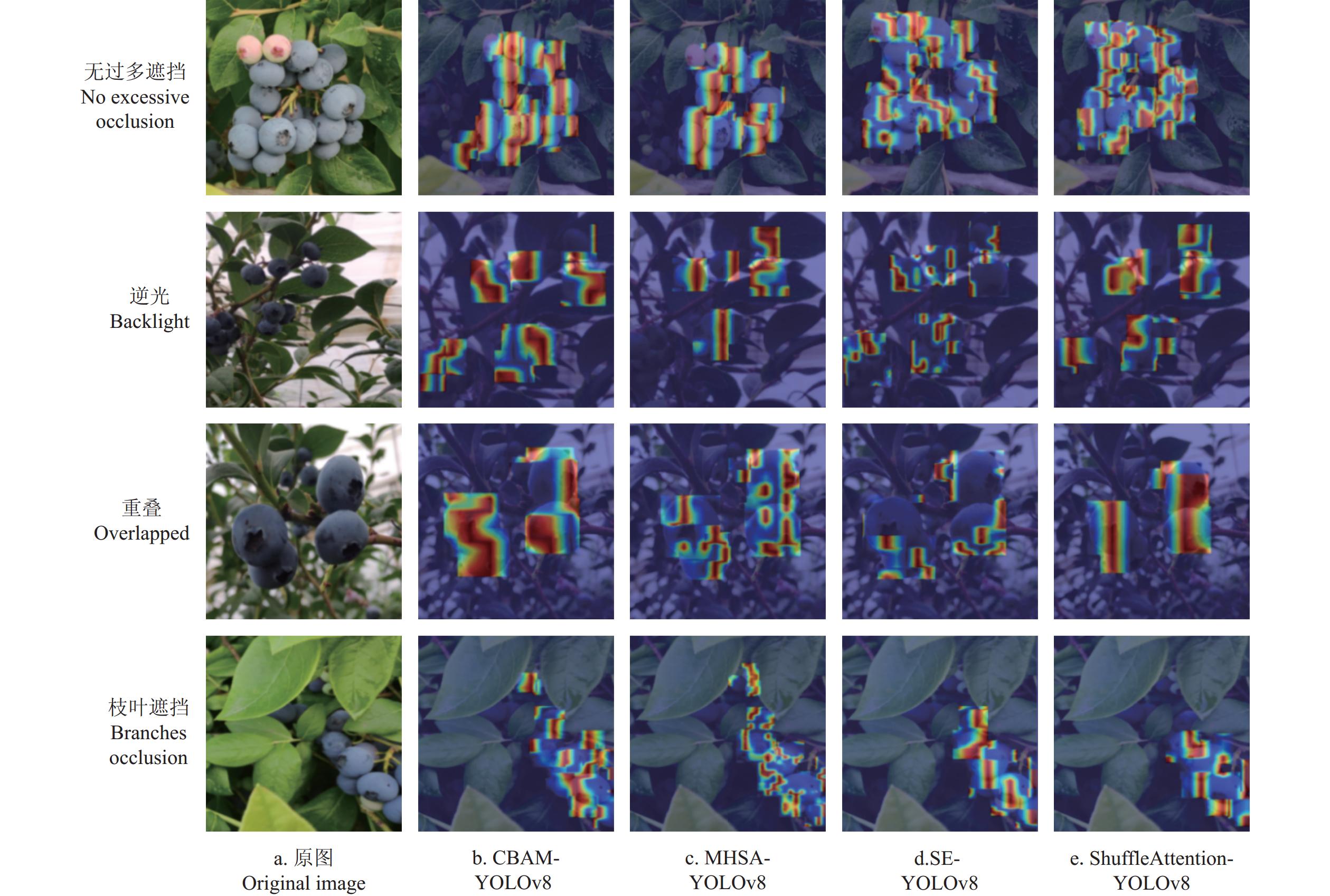

3.2 不同注意力机制算法对比

以YOLOv8为基础模型,在其主干网络DarkNet_53上面引入不同的注意力机制,以有助于模型更有效地提取关键特征,从而提高目标检测框的准确性和精确度。为了更加直观地展示不同注意力机制对蓝莓成熟度特征的影响,本研究采用Grad-CAM[28]中类激活热力图分别对模型的3个输出层进行可视化分析,通过展示类激活热力图,可提高模型的可解释性,试验对比结果如图8所示。图中红颜色鲜亮区域面积越大,表示预测输出关注度越高。

由图8可知,主干网络DarkNet_53引入注意力机制MHSA[29]、ShuffleAttention[30]和SE[31]时,网络对密集蓝莓簇的信息捕获能力不强,尤其是ShuffleAttention注意力机制,关注的信息非常少。而YOLOv8-CBAM注意力机制对蓝莓成熟度特征的关注程度最高,对蓝莓目标的空间位置把握得更加精准,能够更快地定位到感兴趣目标。所以本研究采用CBAM注意力机制检测蓝莓的成熟度。

3.3 优选损失函数结果分析

由于YOLOv8模型原本的CIoU目标检测损失函数存在收敛速度较慢、效率较低的问题,为了解决此问题,本研究将YOLOv8原模型的CIoU分别替换为EIoU[32]、GIoU与SIoU,并将这几种改进的效果进行对比,然后选出效果最好的改进方法。试验对比结果如图9所示。

从图9a可知,原YOLOv8模型存在漏检和误识别情况。从图9b可知,将YOLOv8模型的边界框损失函数调整为EIoU后,模型也出现了漏检和误识别情况,并且在多目标图像的场景下,出现了重复识别的情况,如图片下方的2个蓝莓,就被多个检测框框中。

从图9c可知,将YOLOv8模型的边界框损失函数调整为GIoU,该算法依然存在漏检和误识别情况,有5个蓝莓漏检,2个成熟蓝莓被误识别为欠成熟蓝莓。从图9d可知,将YOLOv8模型的边界框损失函数调整为SIoU,该算法在多目标图像中,针对蓝莓果实遮挡、枝叶遮挡等情况识别效果都较好。

综上所述,将YOLOv8原模型的CIoU替换为SIoU的效果较好。原因可能是SIoU优化预测框与真实框之间的匹配度,使其更接近,从而加快收敛速度,提高效率。

3.4 改进模型消融试验

为验证本研究提出的MSC-YOLOv8模型性能的提升效果,将MSC-YOLOv8和YOLOv8逐步进行对比,以验证每步改进的有效性,对比结果如表3所示。

表 3 模型消融试验结果Table 3. Model ablation experimental resultsMobileNetV3 SIoU CBAM 召回率

Recall R/%平均精度 Average accuracy Ac/% 平均精度均值

Mean of average accuracy mAP/%检测速度

Detection speed/ms参数量

Parameters/M未成熟

Immature欠成熟

Undermature成熟

Mature过成熟

Overmature× × × 93.6 93.8 93.1 94.5 94.2 93.9 11.06 7.86 √ × √ 94.2 96.1 94.0 94.9 97.7 95.6 7.13 7.35 × √ × 95.7 94.3 92.1 96.2 95.4 94.9 10.9 7.89 √ × × 90.7 92.7 93.5 92.3 93.1 92.9 6.89 7.01 × × √ 94.3 94.1 93.3 94.9 94.5 94.2 11.35 7.92 √ √ × 94.1 96.6 95.4 93.1 96.5 95.4 6.97 7.24 × √ √ 93.3 94.7 94.6 93.4 94.8 94.4 11.23 7.95 √ √ √ 97.3 97.1 98.3 97.9 98.1 97.8 7.09 7.11 注:“×”表示未使用此改进策略;“√”表示使用此改进策略。 Note: "×" means that this improvement strategy is not being used; "√" indicates that this improvement strategy is used. 由表3可知,采用原YOLOv8模型,对蓝莓果实成熟度分类识别的mAP为93.9%。在原有的YOLOv8基础上将主干特征提取网络替换成了轻量型网络MobileNetV3,检测速度为6.89 ms,比原YOLOv8减少4.17 ms,说明对YOLOv8模型进行的轻量化改进有显著效果。将YOLOv8主干特征提取网络替换成轻量型网络MobileNetV3,并在主干网络的第4、第6和第9层嵌入了CBAM注意力机制,mAP较原YOLOv8模型增加1.7个百分点,较仅将主干网络替换为MobileNetV3增加2.7个百分点,说明CBAM可以有效抑制背景因素,更多的关注蓝莓特征。将原模型主干网络替换为轻量型MobileNetV3结构,引入CBAM注意力机制,并将边界框损失函数替换为SIoU,mAP为97.8%,为消融试验中最高,较将原模型主干网络替换为轻量型MobileNetV3结构且引入CBAM注意力机制增加2.2个百分点。

综上所述,可以表明本研究对YOLOv8模型的改进有效。消融试验中,将YOLOv8网络边框回归损失函数替换为SIoU并添加CBAM时,其召回率及平均精度均小于单独加入SIoU,原因可能是:同时添加SIoU和CBAM可能需要更加细致的参数调整。如果参数设置不当,可能会导致模型无法充分利用这两个组件的优势,甚至产生冲突。

3.5 不同模型对比

本研究选取单阶段目标检测模型YOLOv8、SSD[33-34]、CenterNet[35]进行对比。其各项性能指标对比结果如表4所示。

表 4 不同模型性能指标对比Table 4. Comparison of performance indicators of different models模型名称

Model参数量

Parameters/M检测速度

Detection speed/msmAP/% R/% MSC-YOLOv8 7.11 7.09 97.8 97.3 YOLOv8 7.86 11.06 93.9 93.6 SSD 8.31 11.35 93.2 92.7 CenterNet 7.92 10.03 96.7 96.1 由表4数据可知,MSC-YOLOv8相较于YOLOv8、SSD和CenterNet,其综合性能最好,其参数量为7.11M,检测时间为7.09 ms,mAP为97.8%,mAP分别提升了3.9、4.6、1.1个百分点,检测时间分别减少了3.97、4.26、2.94 ms。

在完成模型训练后,本研究计划将MSC-YOLOv8模型部署于边缘设备。经过测试,MSC-YOLOv8模型检测速度达到了141帧/s,这一性能显著超出了实时性检测通常要求的30帧/s,因此,其满足实时监测的需求,具备在实际生产环境中应用的潜力。这4个模型在不同环境下的检测效果对比如图10所示。

由图10可知MSC-YOLOv8模型展现出了最高的准确率,并且在所有测试样本中均未出现漏检现象。而在检测重叠的蓝莓果实时,YOLOv8和SSD模型则出现了重复识别的情况;在逆光环境下检测的4幅图中可以看出,MSC-YOLOv8模型无漏检情况,最低置信度为0.92,最高置信度为0.96,SSD模型出现了漏检的情况,而YOLOv8和CenterNet模型的置信度较低;在无过多遮挡环境下检测的4幅图中,MSC-YOLOv8模型检测效果最好;在检测枝叶遮挡的蓝莓果实时,YOLOv8、SSD和CenterNet模型出现了不同程度的漏检情况。

4. 结 论

本研究基于YOLOv8提出了一种改进的轻量化网络模型MSC-YOLOv8,用于蓝莓果实成熟度检测。改进方法为将原模型主干网络替换为轻量型MobileNetV3结构,在主干网络中引入CBAM注意力机制,将原模型的边界框损失函数替换为SIoU。主要结论如下:

1)通过对3种改进方法试验结果对比分析得出,采用MobileNetV3作为主干网络显著提升了模型的实时性,模型参数量达到7.01M;引入CBAM注意力机制有效增强了模型对蓝莓特征的关注度并抑制了背景干扰,而边界框损失函数采用SIoU则进一步减小了漏检机会。这些改进措施有效使蓝莓成熟度检测模型能满足边缘设备应用的需要,可达到实时监测的要求。

2)8组消融试验验证了这些改进的有效性,MSC-YOLOv8在检测速度和平均精度均值(mAP)上均展现出显著优势,单张图片检测速度提升至7.09 ms,比YOLOv8减少3.97 ms,mAP达到97.8%,比YOLOv8的mAP增加3.9个百分点。试验结果表明MSC-YOLOv8 各模块的有效性。

3)改进的MSC-YOLOv8模型在蓝莓数据集上取得了较优的结果,与YOLOv8、SSD、CenterNet等主流模型相比,MSC-YOLOv8在mAP上分别实现了3.9、4.6、1.1个百分点的提升,模型检测速度达到了141帧/s,同时在视觉检测效果上也表现优异。因此,本研究不仅为田间复杂环境下蓝莓果实成熟度的智能检测提供了高效准确的解决方案,也为农产品机器人智能采摘技术的发展奠定了坚实基础。

-

图 3 MSC-YOLOv8模型架构

注:Conv2d为卷积,Concat为通道数相加的特征融合方式,BN为批量归一化,CBAM为卷积注意力块,MNI为MNIneck,Upsample代表上采样。

Figure 3. Network structure of MSC-YOLOv8

Note: Conv2d is convolution, Concat is the feature fusion method of adding the number of channels, BN is bath normalization, CBAM is the convolutional attention block, MNI represents MNIneck, and Upsample represents upsampling.

图 6 角度损失和距离损失示意图

注:B为预测边界框, {B}_{GT} 为真实边界框,图a以真实框中心点和预测框中心点作为对角顶点形成一个矩形, {c}_{w} 和 {c}_{h} 为矩形的宽度和高度,σ为矩形的对角线长度,α为σ与 {c}_{w} 形成的角度度数,β为σ与 {c}_{h} 形成的角度度数;图b中 {c}_{wb} 和 {c}_{hb} 为预测框与真实边界框的最小外接矩形的宽度和高度。

Figure 6. Schematic diagram of angular loss and distance loss

Note: B is the prediction bounding box, {B}_{GT} is the real bounding box, Fig. a takes the center point of the real box and the center point of the prediction box as diagonal vertices to form a rectangular rectangle, the {c}_{w} and {c}_{h} are the width and height of the rectangle, the σ is the diagonal length of the rectangle, the α is the degree of angle formed by the σ and the {c}_{w} , and the β is the degree of angle formed by the σ and the {c}_{h} ; In Figure b, {c}_{wb} and {c}_{hb} are the widths and heights of the minimum enclosed rectangle between the prediction box and the real bounding box.

表 1 MobileNetV3网络结构

Table 1 Network structure of MobileNetV3

输入

Input模块

Layer卷积核

大小

Kernel sizeExp Size 输出通

道数

Output channelSE注意

力机制

SE attention非线性

激活函数

Nonlinearities步距

Stride6402×3 conv2 d 3×3 - 16 × HS 2 1122×16 bneck 3×3 16 16 √ RE 2 562×16 bneck 3×3 72 24 × RE 2 282×24 bneck 3×3 88 24 × RE 1 282×24 bneck 5×5 96 40 √ HS 2 142×40 bneck 5×5 240 40 √ HS 1 142×40 bneck 5×5 240 40 √ HS 1 142×40 bneck 5×5 120 48 √ HS 1 142×48 bneck 5×5 144 48 √ HS 1 142×48 bneck 5×5 288 96 √ HS 2 72×96 bneck 5×5 576 96 √ HS 1 72×96 bneck 5×5 576 96 √ HS 1 72×96 conv2 d 1×1 - 576 √ HS 1 72×576 Pool 7×7 - - × - 1 12×576 conv2 d,NBN 1×1 - 1024 × HS 1 12× 1024 conv2 d,NBN 1×1 - k × - 1 注:Layer中的bneck表示MobileNetV3中的bneck结构,NBN表示不使用BN;Exp size表示bneck中的第一层1×1卷积升维之后的维度大小(第一个bneck没有1×1卷积升维操作);Output channel中的 k 表示bneck最终输出的channel个数;SE attention中的“×”表示不使用SE注意力机制;“√”表示使用SE注意力机制;Nonlinearities中的HS表示HardSwish,RE表示ReLu;stride表示步长(stride=2,长宽变为原来一半)。 Note: The bneck in the layer represents the unique bneck structure in MobileNetV3, as shown in Figure 4, and the NBN indicates that BN is not used. Exp size indicates the first layer of 1×1 convolution in bneck, and how much the dimension is ascended to (the first bneck does not have a 1×1 convolutional dimension upscaling operation); k in the output channel indicates the number of channels that bneck outputs in the end. The "×" in SE attention means that the SE attention mechanism is not used; "√" indicates the use of the SE attention mechanism; HS in Nonlinearities means HardSwish, RE means ReLu; stride represents the step size (stride = 2, the length and width become half). 表 2 不同轻量化改进试验结果

Table 2 Experimental results of different lightweight improvements

模型Models 参数量

Parameters/M检测速度

Detection speed/msYOLOv8 7.86 11.06 YOLOv8-MobileNetV3 7.01 6.89 YOLOv8-Shufflenet 7.06 6.95 YOLOv8-Vanillanet 6.82 6.84 表 3 模型消融试验结果

Table 3 Model ablation experimental results

MobileNetV3 SIoU CBAM 召回率

Recall R/%平均精度 Average accuracy Ac/% 平均精度均值

Mean of average accuracy mAP/%检测速度

Detection speed/ms参数量

Parameters/M未成熟

Immature欠成熟

Undermature成熟

Mature过成熟

Overmature× × × 93.6 93.8 93.1 94.5 94.2 93.9 11.06 7.86 √ × √ 94.2 96.1 94.0 94.9 97.7 95.6 7.13 7.35 × √ × 95.7 94.3 92.1 96.2 95.4 94.9 10.9 7.89 √ × × 90.7 92.7 93.5 92.3 93.1 92.9 6.89 7.01 × × √ 94.3 94.1 93.3 94.9 94.5 94.2 11.35 7.92 √ √ × 94.1 96.6 95.4 93.1 96.5 95.4 6.97 7.24 × √ √ 93.3 94.7 94.6 93.4 94.8 94.4 11.23 7.95 √ √ √ 97.3 97.1 98.3 97.9 98.1 97.8 7.09 7.11 注:“×”表示未使用此改进策略;“√”表示使用此改进策略。 Note: "×" means that this improvement strategy is not being used; "√" indicates that this improvement strategy is used. 表 4 不同模型性能指标对比

Table 4 Comparison of performance indicators of different models

模型名称

Model参数量

Parameters/M检测速度

Detection speed/msmAP/% R/% MSC-YOLOv8 7.11 7.09 97.8 97.3 YOLOv8 7.86 11.06 93.9 93.6 SSD 8.31 11.35 93.2 92.7 CenterNet 7.92 10.03 96.7 96.1 -

[1] 程绍南,陈华江. 我国蓝莓生产快速发展的现状及其展望[J]. 中国果业信息,2022,39(2):15-17. doi: 10.3969/j.issn.1673-1514.2022.02.003 [2] 李亚东,裴嘉博,陈丽,等. 2020中国蓝莓产业年度报告[J]. 吉林农业大学学报,2021,43(1):1-8. LI Yadong, PEI Jiabo, CHEN Li, et al. China blueberry industry report 2020[J]. Journal of Jilin Agricultural University, 2021, 43(1): 1-8. (in Chinese with English abstract)

[3] MUTHA S A, SHAH A M, AHMED M Z. Maturity detection of tomatoes using deep learning[J]. SN Comput Science, 2021, 2: 1-7. doi: 10.1007/s42979-020-00382-x

[4] KO K E, YANG S H I. Real-time tomato ripeness classification system based on deep learning model for object detection[J]. Journal of Institute of Control, Robotics and Systems, 2018, 24: 999-1004. doi: 10.5302/J.ICROS.2018.18.0166

[5] SU F, ZHAO Y, WANG G, et al. Tomato maturity classification based on SE-YOLOv3-MobileNetV1 network under nature greenhouse environment[J]. Agronomy, 2022, 12(7): 1638. doi: 10.3390/agronomy12071638

[6] FAN Y, ZHANG S, FENG K, et al. Strawberry maturity recognition algorithm combining dark channel enhancement and YOLOv5[J]. Sensors, 2022, 2: 419.

[7] DANH P H, MY V V, NGHIN V D, et al. Classifying maturity of cherry tomatoes using deep transfer learning techniques[J]. In IOP Conference Series: Materials Science and Engineering, 2021, 1109(1): 12058. doi: 10.1088/1757-899X/1109/1/012058

[8] CHEN S, XIONG J, JIAO J, et al. Citrus fruits maturity detection in natural environments based on convolutional neural networks and visual saliency map[J]. Precision Agriculture, 2022, 23(5): 1515-1531. doi: 10.1007/s11119-022-09895-2

[9] MACEACHERN C B, ESAU T J, SCHUMANN A W, et al. Detection of fruit maturity stage and yield estimation in wild blueberry using deep learning convolutional neural networks[J]. Smart Agricultural Technology, 2023, 3: 100099. doi: 10.1016/j.atech.2022.100099

[10] 王立舒,秦铭霞,雷洁雅,等. 基于改进YOLOv4-Tiny的蓝莓成熟度识别方法[J]. 农业工程学报,2021,37(18):170-178. doi: 10.11975/j.issn.1002-6819.2021.18.020 WANG Lishu, QIN Mingxia, LEI Jieya, et al. Blueberry maturity recognition method based on improved YOLOv4-Tiny[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 170-178. (in Chinese with English abstract) doi: 10.11975/j.issn.1002-6819.2021.18.020

[11] RADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[J]. Computer Science, 2015, 15(11): 6434.

[12] 马超伟,张浩,马新明,等. 基于改进YOLOv8的轻量化小麦病害检测方法[J]. 农业工程学报,2024,40(5):187-195. MA Chaowei, ZHANG Hao, MA Xinming, et al. Method for the lightweight detection of wheat disease using improved YOLOv8[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2024, 40(5): 187-195. (in Chinese with English abstract)

[13] 周宏平,金寿祥,周磊,等. 基于迁移学习与YOLOv8n的田间油茶果分类识别[J]. 农业工程学报,2023,39(20):159-166. doi: 10.11975/j.issn.1002-6819.202307244 ZHOU Hongping, JIN Shouxiang, ZHOU Lei, et al. Classification and recognition of camellia oleifera fruit in the field based on transfer learning and YOLOv8n[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(20): 159-166. (in Chinese with English abstract) doi: 10.11975/j.issn.1002-6819.202307244

[14] ROY A M , BOSE R , BHADURI J. A fast accurate fine-grain object detection model based on YOLOv4 deep neural network[J]. Neural Computing and Applications, 2022, 34(5): 3895-3921.

[15] LIN T, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]. //IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, 2017: 936-944.

[16] HOWARD A, SANDLER M, CHEN B, et al. Searching for MobileNetV3[C]. //Proceedings of the IEEE International Conference on Computer Vision, Seoul, 2019: 1314-1324.

[17] WOO S , PARK J , LEE J Y , et al. CBAM: Convolutional block attention module[C]. //Proceedings of the European Conference on Computer Vision (ECCV), Munich, 2018: 3-19.

[18] 苗荣慧,李志伟,武锦龙. 基于改进YOLO v7的轻量化樱桃番茄成熟度检测方法[J]. 农业机械学报,2023,54(10):225-233. doi: 10.6041/j.issn.1000-1298.2023.10.022 MIAO Ronghui, LI Zhiwei, WU Jinlong. Lightweight maturity detection of cherry tomato based on improved YOLOv7[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(10): 225-233. (in Chinese with English abstract) doi: 10.6041/j.issn.1000-1298.2023.10.022

[19] SUN J, YANG Y, HE X, et al. Northern maize leaf blight detection under complex field environment based on deep learning[J]. IEEE Access, 2020, 8: 33679-33688.

[20] WANG X, SONG J. ICIoU: Improved loss based on complete intersection over union for bounding box regression[J]. IEEE Access, 2021, 9: 105686-105695.

[21] ZHAO Z, WANG J, ZHAO H. Research on apple recognition algorithm in complex orchard environment based on deep learning[J]. Sensors, 2023, 23(12): 5425. doi: 10.3390/s23125425

[22] WANG W, LI S, SHAO J, et al. LKC-Net: large kernel convolution object detection network[J]. Scientific Reports, 2023, 13(1): 9535. doi: 10.1038/s41598-023-36724-x

[23] 龙燕,杨智优,何梦菲. 基于改进YOLOv7的疏果期苹果目标检测方法[J]. 农业工程学报,2023,39(14):191-199. LONG Yan, YANG Zhiyou, HE Mengfei. Recognizing apple targets before thinning using improved YOLOv7[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(14): 191-199. (in Chinese with English abstract)

[24] CHAKROUN I , HABER T , ASHBY T J . SW-SGD: The sliding window stochastic gradient descent algorithm[J]. Procedia Computer Science, 2017, 108: 2318-2322.

[25] 周志华. 机器学习[M]. 北京:清华大学出版社,2015:24-27. [26] CHEN H, WANG Y, GUO J, et al. Vanillanet: The power of minimalism in deep learning[J]. Advances in Neural Information Processing Systems, 2024, 36: 1-15.

[27] ZHANG X, ZHOU X, LIN M, et al. Shufflenet: An extremely efficient convolutional neural network for mobile devices[C]. //In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition , Salt Lake City, 2018: 6848-6856.

[28] SELVARAJU R R, COGSWELL M, DAS A, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization[J]. International Journal of Computer Vision, 2020, 128: 336-359. doi: 10.1007/s11263-019-01228-7

[29] LIU Y, WU Y H, SUN G, et al. Vision transformers with hierarchical attention[J]. Machine Intelligence Research, 2024, 21: 1-14.

[30] SHI Y, LI X, WANG G, et al. Research on the recognition and classification of recyclable garbage in a complex environment based on improved YOLOv8s[J]. International Conference on Control and Robotics, 2023, 5: 230-235.

[31] FUCHS F, WORRAL D, FISCHER V, et al. Se (3)-transformers: 3d roto-translation equivariant attention networks[J]. Advances in neural information processing systems, 2020, 33: 1970-1981.

[32] WANG S Y, QU Z, GAO L Y. Multi-spatial pyramid feature and optimizing focal loss function for object detection[J]. IEEE Transactions on Intelligent Vehicles, 2023, 9(1): 1054-1065.

[33] LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]. //Proceedings of the European Conference on Computer Vision (ECCV), 2016, 21–37.

[34] NI J, SHEN K, CHEN Y, et al. An improved ssd-like deep network-based object detection method for indoor scenes[J]. IEEE Transactions on Instrumentation and Measurement, 2023, 72: 1-15.

[35] JIN X , SUN Y , CHE J , et al. A novel deep learning‐based method for detection of weeds in vegetables[J]. Pest Management Science, 2022, 78(5): 1861-1869.

-

期刊类型引用(4)

1. 董适 ,赵国瑞 ,苟豪 ,文剑 ,林晨 . 基于改进RT-Detr的黄瓜果实选择性采摘识别方法. 农业工程学报. 2025(01): 212-220 .  本站查看

本站查看

2. 任锐,孙海霞,张淑娟,杨盛,景建平. 基于改进YOLOv8n的不同栽培模式下玉露香梨轻量化检测. 农业工程学报. 2025(05): 145-155 .  本站查看

本站查看

3. 师翊,王应宽,王菲,卿顺浩,赵龙,宇文星璨. MCBPnet:一种高效的轻量级青杏识别模型. 农业工程学报. 2025(05): 156-164 .  本站查看

本站查看

4. 李莹,刘梦莲,何自芬,娄杨伟. 基于改进YOLOv8s的柑橘果实成熟度检测. 农业工程学报. 2024(24): 157-164 .  本站查看

本站查看

其他类型引用(0)

下载:

下载: